要約

BARTでのBERTとの違いは以下の3つの特徴

- エンコーダーとデコーダーの両方を用いて事前学習

- デコーダーのそれぞれのレイヤーでエンコーダーの最後の層との隠れ状態とのクロスアテンションレイヤーを追加

- BERTでは単語予測のためにFEED-FORWARDネットワークを取り入れていたが、BEATでは行わなかった。

事前学習

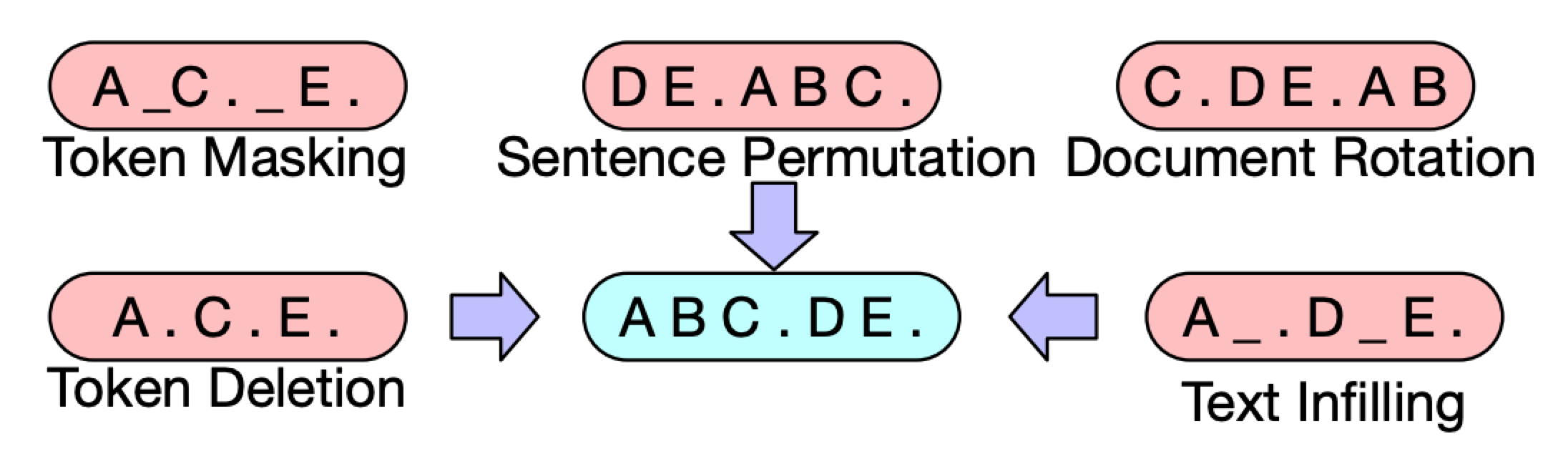

図のようにエンコーダーとデコーダーの両方を使って事前学習を行った。 事前学習の手法は以下の7つを行った

- 単語マスキング

- 単語削除

- 単語列のマスキング

- 単語の並び替え

- 文章回転

図にあらあわすと上図の通り。

単語マスキングでは予測する単語に_というマスキングを施す 単語削除では任意の単語を削除して.で置き換える 単語列のマスキングでは複数単語(BC)に_というマスキングを施す 単語の並び替えでは単語の順番を入れ替える。 文章回転では、単語の並びを保持したまま最初の単語を入れ替える